DeepSeek 系列

DeepSeek-V2

论文:DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model

DeepSeek-V3

DeepSeek-R1

论文: DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning

参考: 科学网—DeepSeek-R1 100问

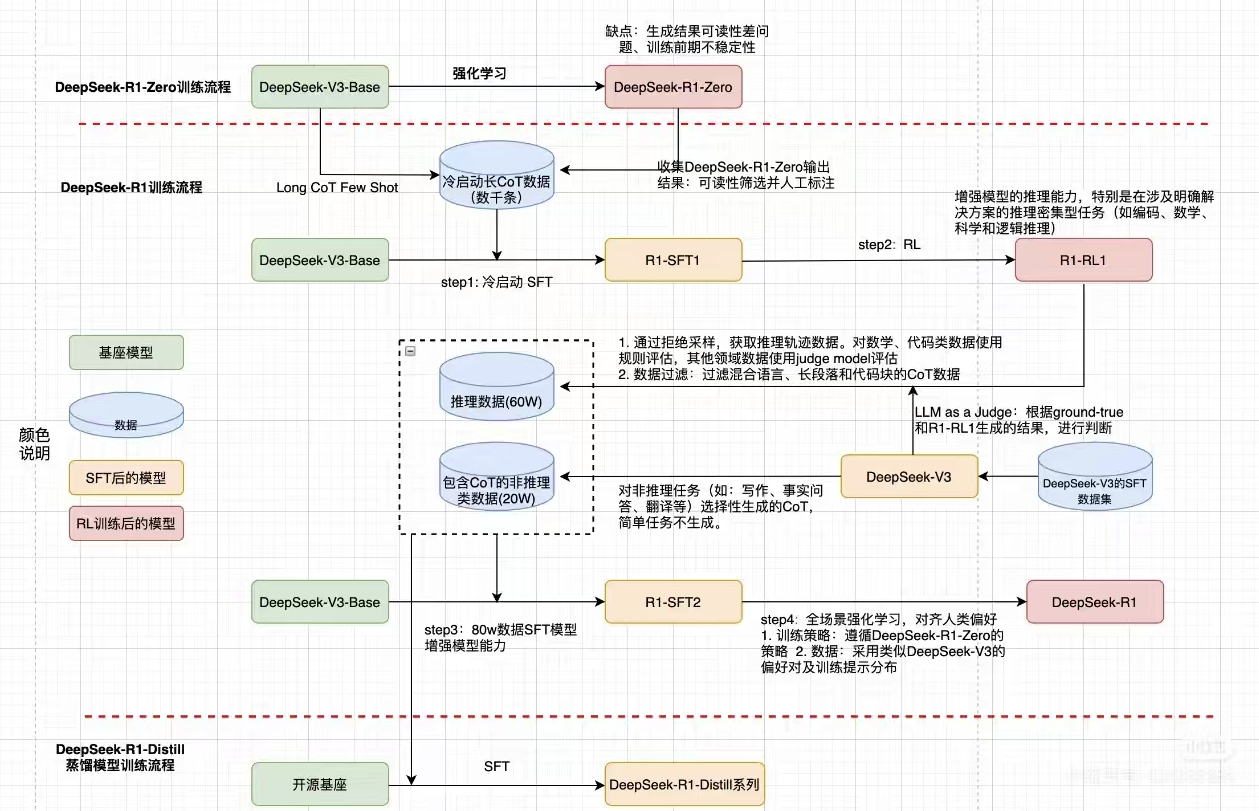

主要包含两个模型:DeepSeek-R1-Zero 和 DeepSeek-R1

DeepSeek-R1-Zero 通过大规模强化学习(RL)训练,无需 SFT 作为前置初步步骤。在强化学习过程中 Deep Seek-R1-Zero 自然而然地出现了许多强大而有趣的推理行为。

DeepSeek-R1在 RL 之前结合了多阶段训练和冷启动数据,来解决 Zero 的可读性差、语言混合等问题。

Introduction

研究背景: post-training 已被证明可以提高推理任务的准确性、与社会价值对齐、适应用户偏好、需要相对预训练最少的计算资源。OpenAI 首先提出通过增加思想链 CoT 推理过程的长度来引入 Inference time Scaling,后续工作探索有效的 test-time Scaling 的工作包括利用 PRM(过程奖励模型)以及 MCTS 和 Beam Search 等Search 方法,但是都没有达到媲美 OpenAI-o1 的推理能力的程度。

研究内容:

本文探索使用纯粹的的强化学习(Pure Reinforcement Learning)来增强大模型的推理能力,而不使用 SFT 先微调模型,依靠大模型在 RL 过程中自己的 self-evolution 能力

纯粹 RL 训练出来的 DeepSeek-R1-Zero 模型出现可读性低、语言混合的问题,本文研究通过少量冷启动 (cold-start) 数据 和 多阶段训练来解决上述问题并进一步提升推理能力,得到 DeepSeek-R1

本文还探索从 DeepSeek-R1 蒸馏到小模型的效果

研究责献:

在 Base Model上进行大规模强化学习:通过直接在 Deepseek-V3-base 上进行强化学习,DeepSeek-R1-Zero 展示了 self-verification, reflection 和生成长 CoT 等功能。大模型可以纯靠强化学习学习,而不需要SFT过程;介绍了 DeepSeek-R1de pipeline.

蒸馏:证明了较大模型的推理模式可以很好的蒸馏到较小的模型,取得很好的成绩。