IntenVL 系列

InternVL

项目地址: https://github.com/haotian-liu/LLaVA

论文: InternVL Technical Report

动机

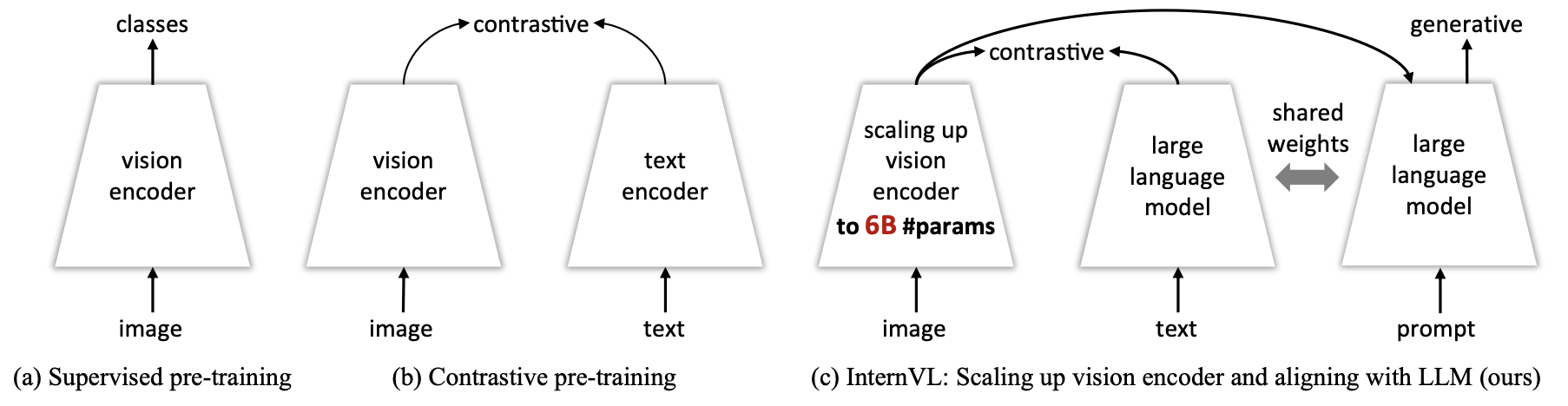

当前多模态大模型都是 Image Encoder + glue layer + LLM,但 Image Encoder + glue layer 的参数量远小于 LLM,导致图文信息没有得到好的融合。InternVL 通过缩放 Image Encoder + glue layer 到 LLM 的参数规模,在视觉分类、语义分割、图文检索、视频检索、视频问答、图文问答等一系列任务取得更好的结果,开放榜单超过 GPT4V取得 sota。

模型架构

- 视觉编码器:InternViT-6B

- 中间件(模态对齐层):QLLaMA(8B,由多语言 LLaMA-7B 初始化 + 1B 可学习 query)

- LLM 模块:Vicuna-13B

训练策略

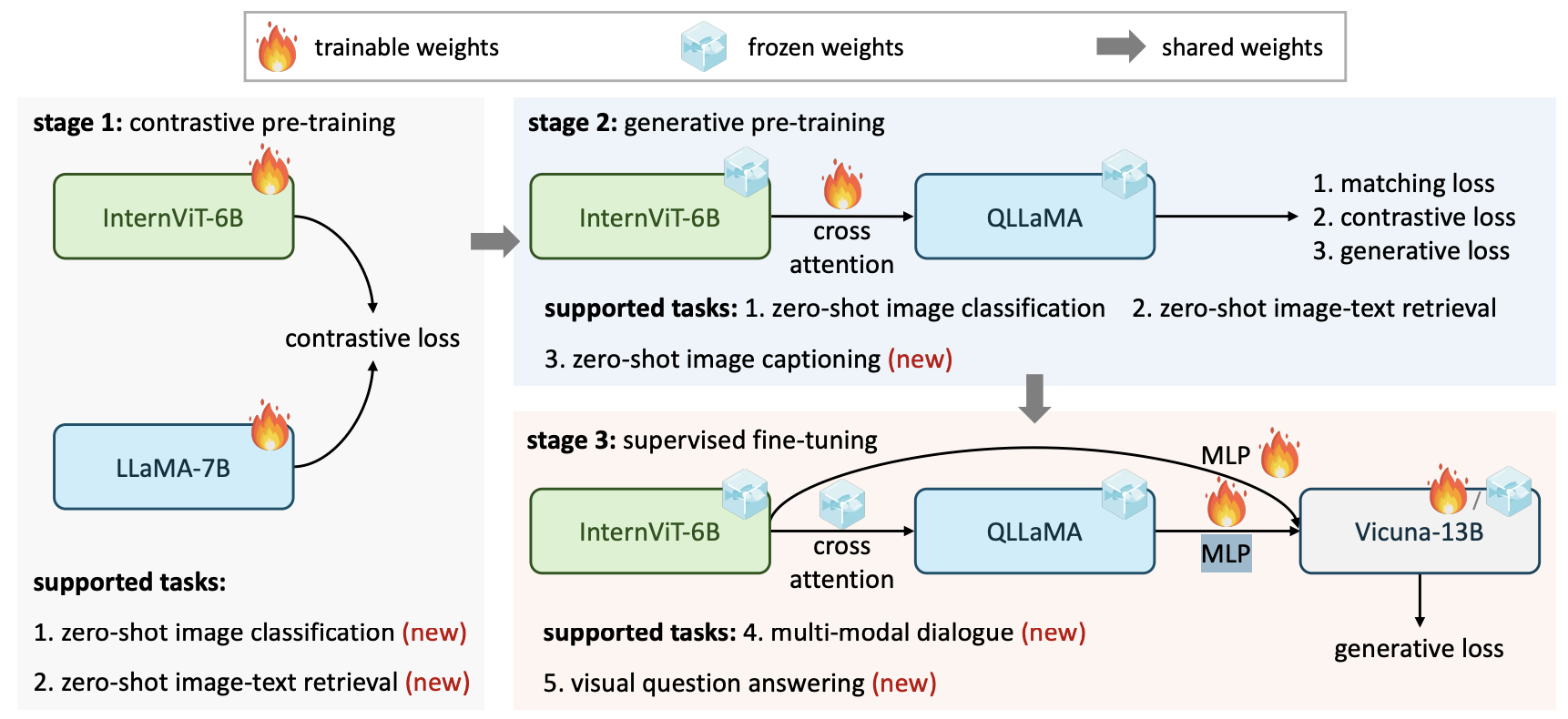

模型整体架构为加强版的 BLIP2 模型,总共分为三阶段训练:

- 图文对比学习:从 60 亿开源图文对中清洗出 49.8 亿进行对比学习,两种形式,分别计算(InternVL Attention pooling 的向量和 EOS token embedding 对应投影后的cosine)、(query Attention pooling 的向量和 EOS token embedding 对应的投影后的 cosine),投影后 embedding 维度为 768

- 图文生成训练:进行 BLIP2 的 ITC、ITM、ITG 图文对齐训练,10 亿图文对,冻结上一步的 InternViT-6B和 LLaMA-7B,训练可学习的 query

- 监督微调:4M 数据,包含图文标题生成 caption、图文 OCR、视觉问答 VQA进行微调。

IntenVL 系列

https://guokent.github.io/papernotes/internvl/