TULIP

论文: https://arxiv.org/abs/2503.15485

项目地址: https://github.com/tulip-berkeley/open_clip

背景

CLIP 和 SigLIP 图文对比学习在需要高保真的图像理解任务,如计数、细粒度物体识别中效果不行。因为 CLIP 和 SigLIP 通过执行语言对齐,往往优先考虑高级语义(意思就是大致内容)而非视觉理解,从而削弱了图像理解能力。

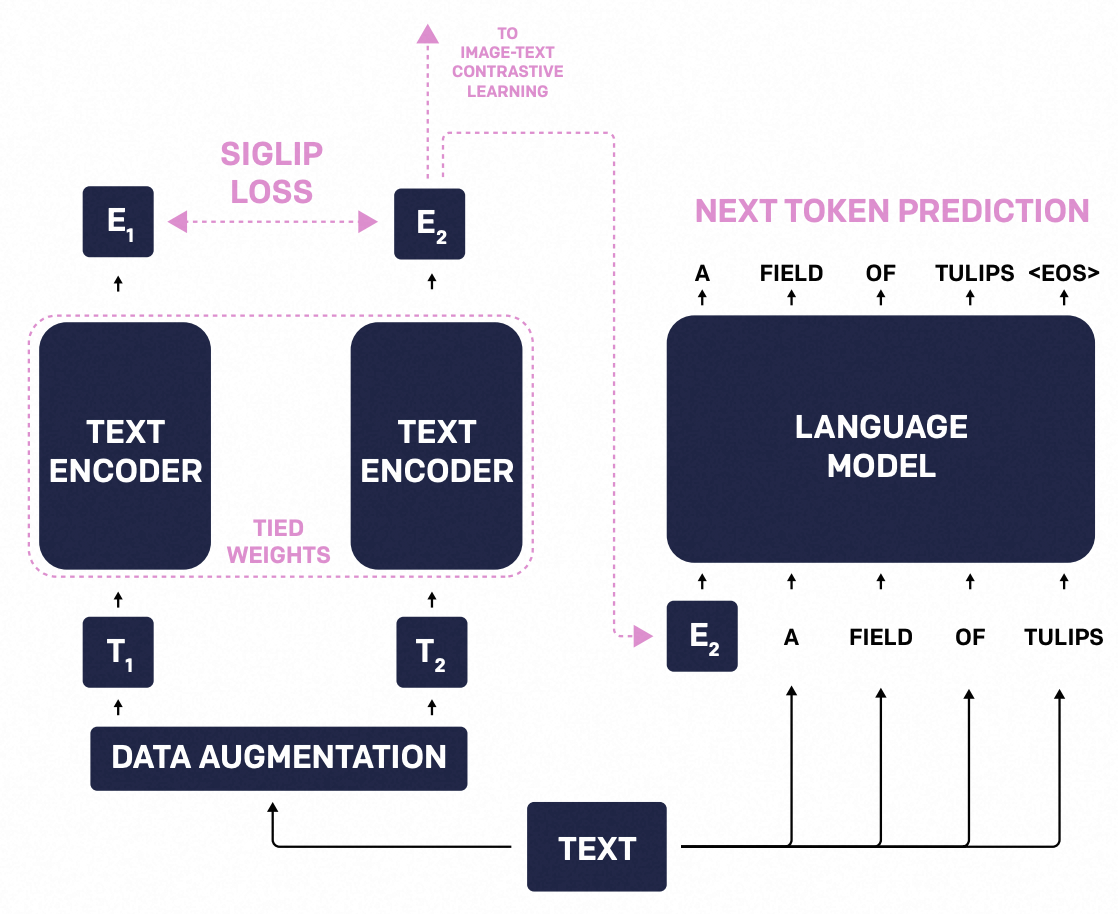

TULIP 利用生成数据增强、增强型图文对比学习和文本对比学习,以及图文重构正则化来学习细粒度视觉特征,同时保持全局语义对齐。

数据

- 预训练:使用 DataComp-1B 数据集,共 5 亿个样本

- Adam:lr=1e-5,decay=1e-4,gradient clipping norm=2

- batch size=49152

- 32 A100

训练策略

总共包含三部分:

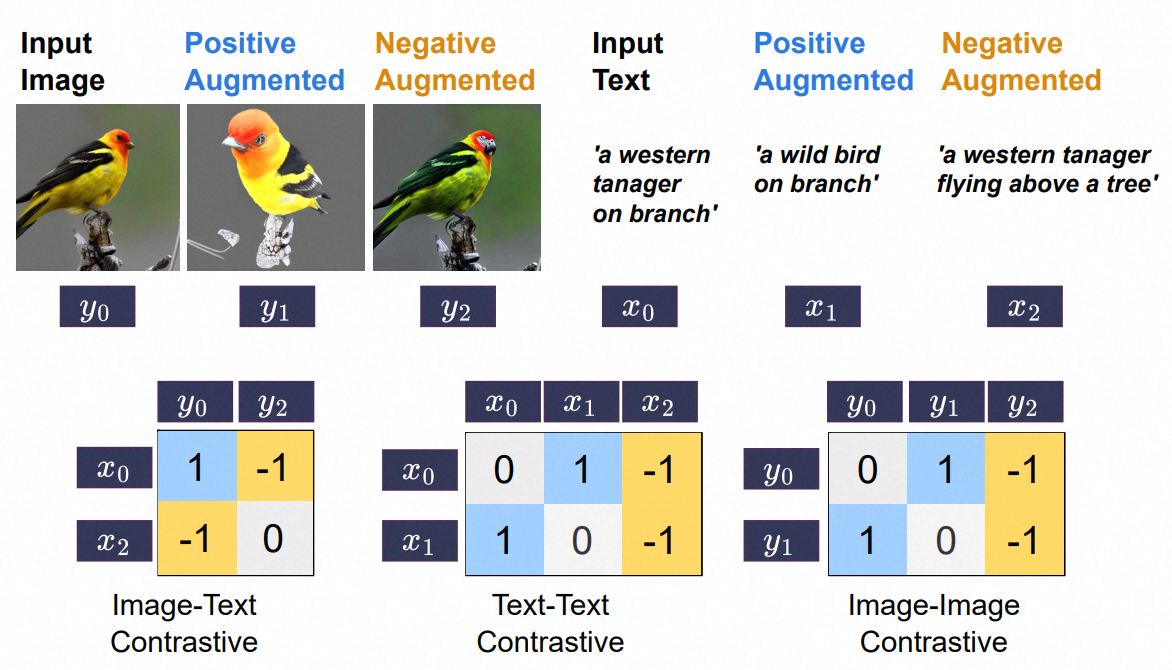

- 图-文对比学习

- 图-图对比学习,图像与自身的增强

- 文-文对比学习,文本与自身的增强

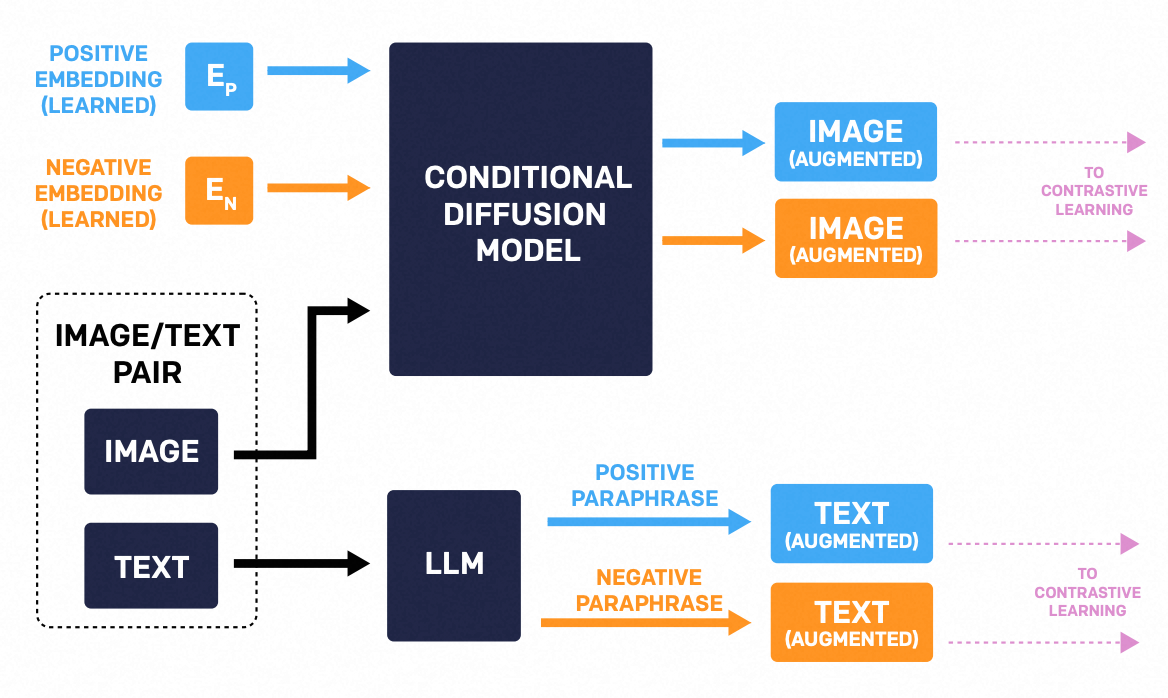

数据增强

- 图像增强:通过字节的 GeCo 框架实现图像生成来增强数据集,从现有图像分别生成正视图(相似)和负视图(截然不同)的图片。为了增强图像,通过 soft prompt 和指令微调生成模型,学习正视图和负视图的 embedding

- 文本增强:通过 llama 实现相似风格增强,同样生成正样本和负样本

TULIP

https://guokent.github.io/papernotes/tulip/